고정 헤더 영역

상세 컨텐츠

본문 제목

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding 논문 한글 번역 - 5

본문

BERT논문을 직역 및 의역으로 작성한 내용입니다.

4 Experiments는 다음 컨텐츠를 이용바랍니다.

https://ynebula.tistory.com/58

5 Ablation Studies

이번 섹션에서 우리는 상대적인 중요성을 좀 더 이해하기 위해서 BERT를 다양한 측면에서 ablation experiments를 수행하였습니다. 추가적인 ablation 연구는 부록 C에서 확인할 수 있습니다.

5.1 Effect of Pre-training Tasks

우리는 같은 pre-training data와 fine-tuning scheme 그리고 hyperparamters를 사용하는 두 pre-training objectives를 평가하여 DBER의 deep bidirectionality 중요성을 설명합니다(as BERTBASE).

No NSP: MLM을 사용하여 훈련된 bidirectional model 그러나 NSP는 사용하지 않음.

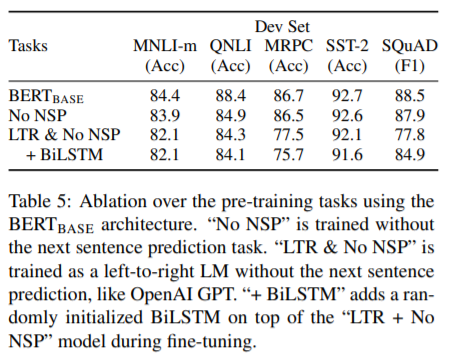

LTR(Left-to-Right - LTR을 사용하여 훈련된 left-context-only model) & NSP: left-only 제약은 fine-tuning에도 적용됩니다(pre-train/fine-tune mismatch는 downstream 성능을 저하시키므로). 추가로, 이 모델은 NSP task없이 pre-train됩니다. OpenAI GPT와 비교하여, 더 큰 dataset과 input representation, fine-tuning schem을 사용합니다. 우리는 NSP의 영향을 시험했습니다. Table 5를 보면, NSP 제거는 QNLI, MNLI, SQuAD 1.1에 상당히 나쁜 영향을 주었습니다.

다음으로, bidirectional representations을 훈현하는 영향을 평가했습니다(No NSP, LTR & No NSP). LTR 모델은 모든 task에서 MLM 모델보다 더 나쁜 성능을 보였습니다. 특히, MRPC와 SQuAD에서 많이 떨어졌습니다.

SQuAD에서 LTR 모델은 token prediction에서 나쁜 성능을 낼거란걸 직관적으로 예상합니다(token-level hidden states는 right-side context가 없기 때문). LTR 시스템을 개선하기 위해, 랜덤하게 초기화된 BiLSTM을 top에 추가하였습니다. 이것은 SQuAD에 상당한 성능 향상을 보였습니다. 그러나 여전히 pre-train된 bidirectional model 보다는 좋지 않았습니다. BiLSTM은 GLUE task에서는 나쁜 성능을 냈습니다.

우리는 LTR과 RTL모델을 분리하여 훈련하는 것과 ELMo와 같이 두 model을 합쳐서 토큰을 표현할 수 있다는걸 알게되었습니다.

However:

(a) single bidirectional model은 두 배의 비용이 들어감

(b) QA와 같은 task에는 non-intuitive함(RTL model은 질문에 답을 할 수 없기때문)

(c) deep bidirectional 모델 보다는 덜 효과적 임(모든 layer에서 양 방향(left and right) context를 사용하기 때문).

5.2 Effect of Model Size

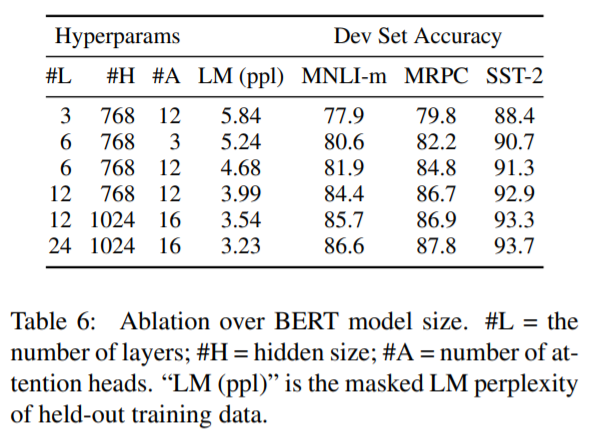

이번 섹션에서, model size가 fine-tuning accuracy에 미치는 영향을 확인 하겠습니다. 우리는 같은 hyperparameters와 training절차로 다른 수의 layer, hidden unit, attention head로 여러 BERT모델을 학습했습니다.

GLUE task의 결과는 Table 6에서 확인할 수 있습니다. Table 6에서, 우리는 5random restarts fine-tunning의 평균 DEV Set accuracy를 리포트 했습니다. 모든 dataset에서 큰 모델이 accuracy 향상을 확인했습니다. pre-training task는 다르고, 심지어 MRPC 3,600 labeled traing exmaple를 가진 MRPC에서도 더 좋은 성능을 보였습니다. 기존 leterature에 비해 이미 상당히 큰 모델을 통해 상당한 성능 향상을 얻을 수 있다는 것은 놀라운 일입니다.

예를들어, 가장 큰 Transformer의 encoder는 (L=6, H=1024, A=16)와 100M paramters로 연구하였습니다.

그리고 우리가 가진 가장큰 Transformer는 ......

대조적으로, BERTBASE는 110M parameters와 BERTLARGE는 340M parameters를 가지고 있습니다.

Table 6에서 보여준, LM perplexity of held-out training data 설명되었던 machine trranslation과 language modeling과 같은 large-scale task에서 model size크기를 증가시키면 연속적인 성능향상을 보인다는 것은 오랜 시간동안 알려져 왔습니다. 하지만, 우리는 충분히 pre-train된 모델이라면, 매우 작은 규모의 작업에서도 크게 개선된다는 것을 보여주는 첫 번째 작업이라는 것을 믿습니다. Peters et al. (2018b) presented mixed results on the downstream task impact of increasing the pre-trained bi-LM size from two to four layers and 그리고 Melamud et al. hidden dimension size를 200에서 600으로 늘려서 도움이 됐다고 말했습니다. 그러나 1000 이상은 성능향상이 없다고 말했습니다. 두 개 모두 feature-based 방법을 사용했습니다.

we hypothesize that when the model is fine-tuned directly on the downstream tasks and uses only a very small number of randomly initialized additional parameters, the taskspecific models can benefit from the larger, more expressive pre-trained representations even when downstream task data is very small.

A Additional Details for BERT 는 다음 컨텐츠를 이용바랍니다.

https://ynebula.tistory.com/60

댓글 영역