고정 헤더 영역

상세 컨텐츠

본문

강화 학습 이론은 동물 행동에 대한 심리적, 신경 과학적 관점에 중점을 두어 에이전트가 환경을 어떻게 최적화 할 수 있는지에 대한 설명을 제공합니다.

이전 강화학습 에이전트는 다양한 영역에서 성공을 달성했지만 이는 사람이 인지한 영역, 즉 사람이 완전히 관찰할 수 있는 낮은 차원의 영역에서만 가능했습니다.

여기서 우리는 deep neural network을 사용한 DQN(Deep Q Network)이라 불리는 novel artificial agent를 알아보겠습니다. 이 에이전트는 강화학습을 사용하여 고차원의 데이터를 입력 받아 바로 정책(policy)를 생성합니다.

이 방법은 고전적 게임인 Atari 2600 게임의 어려운 영역에서 이 에이전트를 테스트했습니다. 동일한 알고리즘, 네트워크 아키텍처 및 하이퍼 패러미터를 사용하여 픽셀 및 게임 점수 만 입력으로 받은 DQN 에이전트는 이전 알고리즘의 성능을 능가하고 49 게임 세트의 전문 인간 게임 테스터와 비슷한 수준을 달성 할 수 있었습니다.

Agent는 게임기로부터 받은 pixel(state)를 정보를 바탕으로 action을 취하고 이에 대한 보상(scores)를 받습니다. 최대의 점수를 받을 수 있도록 agent는 학습합니다.

강화학습이란?

강화 학습(Reinforcement learning)은 기계 학습의 한 영역이다. 행동심리학에서 영감을 받았으며, 어떤 환경 안에서 정의된 에이전트가 현재의 상태를 인식하여, 선택 가능한 행동들 중 보상을 최대화하는 행동 혹은 행동 순서를 선택하는 방법이다.

강화학습의 개념이 처음 나온 지는 벌써 수십 년이 흘렀지만 일반 머신러닝 커뮤니티에서 가지는 영향력은 상대적으로 매우 작았습니다. 최근에 또 하나의 중요한 머신러닝의 패러다임이 자리를 잡고 나서야 강화학습이 비로소 그 진가를 드러내게 되었습니다. 그 패러다임이 바로 딥러닝(Deep Learning)입니다. 다계층 신경망과 관련된 그 어떤 기술도 딥러닝이라고 할 수 있습니다.

다계층 신경망이 학습한 복잡한 표현(representation)과 강화학습 에이전트의 귀납적 학습을 결합함으로써 컴퓨터는 비로소 수십 개의 아타리 게임에서 사람의 능력을 넘어서거나 바둑 세계 챔피언을 이기는 등 놀라운 성과를 달성할 수 있게 됩니다

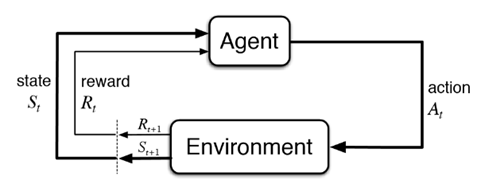

강화학습의 전체 flow는 다음과 같습니다. 에이전트(행위자-agent)의 액션(행위-action)은 환경(world, environment)에 영향을 줍니다. 특정 액션은 환경의 상태(state)를 변화시키고 이에 따라 에이전트는 보상(reward)을 받게 됩니다. 이를 그림으로 표현하면 아래와 같습니다.

강화학습 알고리즘에서는 에이전트가 관찰을 통해 환경으로부터 얻는 보상과 취할 수 있는 액션 즉 보상과 액션의 정확한 쌍을 학습할 수 있게 해야만 합니다. 에이전트는 어떤 액션을 취해야만 시간의 흐름에 따라 가장 큰 보상을 가져올지를 스스로 학습해야만 합니다. 이러한 개념을 다른 말로 할인된 기대 보상(discount expected reward)의 최적화라고 합니다.

강화학습의 목적은 최고의 보상을 얻는 액션을 선택하는 것입니다. 이를 위해 여러 가지 에피소드를 나열합니다. 이를 정책이라고 합니다. 정책은 주어진 환경의 어떤 상황에서 어떤 에이전트가 취하게 되는 일련의 액션을 기술합니다. 에이전트가 주어진 환경 내에서(시간이 경화 후 최종적으로) 최대의 보상을 얻는 정책을 최적의 정책으로 간주하게 됩니다.

강화학습의 세가지 요소

1. 액션 의존성 : 각 액션은 다른 보상을 가져옵니다. 밴딧 문제의 경우 손잡이 A를 당길 때와 손잡이 B를 당길 때의 보상은 다릅니다.

2. 시간 의존성 : 보상은 시간이 지연되고 나서야 주어집니다. 에이전트가 미로 안에 있는 경우를 가정해 보겠습니다. 우리는 이 에이전트가 미로를 빠져나가는 경로를 학습하기를 바랍니다. 시간 의존성이란 미로의 어떤 분기점에서 왼쪽으로 가는 것이 옳은 선택이라고 하더라도 에이전트는 그것이 옳은 선택이었다는 사실을 미로를 완전히 빠져나가서야 알게 된다는 뜻 입니다. 즉 에이전트는 보상에 대해 지연된 시점에 학습하게 되며, 또한 그 보상은 자주 있는 것이 아니라 드문드문(sparse) 있다는 뜻입니다. 에이전트를 학습시키는 알고리즘에서는 반드시 이를 염두에 둬야만 합니다.

3. 상태 의존성 : 어떤 액션에 대한 보상은 환경의 상태에 좌우됩니다. 앞에서 가정한 미로 예를 다시 생각하면, 어떤 분기점에서는 왼쪽으로 가는 것이 이상적이지만 다른 분기점에서는 그렇지 않을 수 있습니다. 이런 경우에 에이전트는 적절한 액션을 취하기 위해 환경의 특성을 이해할 필요가 있게 됩니다.

감사합니다.

[Reference]

강화학습 첫걸음

댓글 영역